<PR> START: Self-taught Reasoner

· 阅读需 10 分钟

一、解决的问题

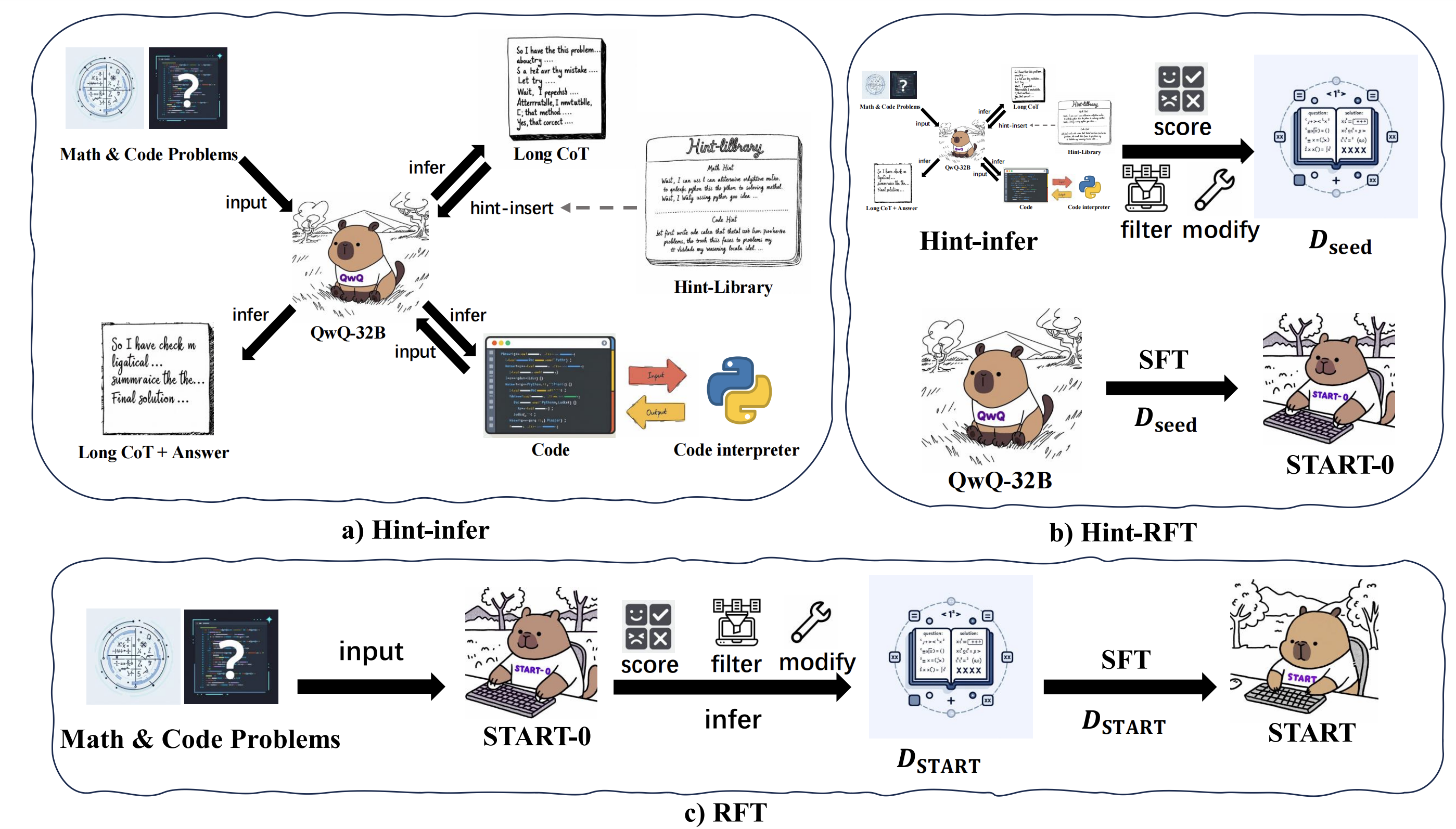

这篇论文主要解决了大语言模型在复杂推理任务中存在的幻觉和效率低下问题,提出了 START(Self-Taught Reasoner with Tools)模型,将长思维链(Long CoT)与工具集成推理(TIR)相结合,提升模型推理能力。

LLMs 复杂推理存在的问题:大语言模型在复杂推理任务中,长思维链方法虽然有一些效果,但依赖仅仅是依靠自身的不断反思机制来提升推理效果,这个方法的上线是十分有限的。

人类面对复杂问题该如何解决

让我们假设一个场景:一个高中学生不借助任何外部工具,在面对一个复杂的数学问题时,仅仅凭借自己的长时间思考来心算,其实很难解决大部分的问题,更多的是需要差资料、在草稿纸上推导 & 计算,甚至是在网上差一些这类题目的相似解题思路,此时我相信解题的正确率会大大提升。

所以大模型在面对复杂计算或模拟时仅仅是通过 Inter-Think 其实很容易产生幻觉。例如,OpenAI-o1 和 DeepSeek-R1 也存在此类问题。

这篇论文就是为了持续提升大模型在复杂问题上的推理能力。

二、方法介绍